Die Rohbildverarbeitung

Der Workflow sieht vor, nachdem der digitalisierte Film als Folge von Rohbild-Dateien vorliegt, diese in der gleichen Weise zu entwickeln, wie es für „normale“ Fotografien üblich ist, und sie anschließend als eine Folge von TIFF-Bildern mit verringerter Pixelauflösung und Farbtiefe zu exportieren. Abschließend werden dann diese TIFF-Bilder neu zu Film-Sequenzen zusammengesetzt.

Zur Frage der Farbtiefe bzw. der Bitauflösung wurde bereits im Teil „Die Filmabtastung, Kapitel 4.4 einiges erklärt. Daraus folgte, dass die Rohbilder eine um wenigstens 2 Bit höhere Farbtiefe aufweisen müssen, als im Zielformat verarbeitet, also mindestens 10 Bit, besser 12 Bit pro Kanal anbieten sollen – und dies, ohne vorher schon durch Kamera-Parameter in Farbe oder Gradation verbogen worden zu sein. Nicht zuletzt aus dieser Überlegung folgte:

Die Anforderungen an ein für die Weiterverarbeitung geeignetes Kamera-Bilddatei-Format werden nur vom Rohbildformat RAW erfüllt.

1 Das RAW-Format

Ein Kamera-Rohbild liefert, je nach verwendeter Kamera, eine Farbtiefe von typischerweise ca. 12 Bit pro Grundfarbe Rot, Grün und Blau bei einem unkomprimierten oder verlustfrei komprimierten Bildinhalt. Ein solches RAW- oder Rohbild zeichnet sich dadurch aus, dass es für jedes Kamerapixel genau den Helligkeitswert speichert, der bei der Aufnahme original vom Bildsensor gewonnen und je nach gewähltem Empfindlichkeitswert (ASA) verstärkt wurde. Die Pixelinformationen sind also neben der Bildinformation selbst nur von der gewählten Empfindlichkeit und den Belichtungseinstellungen abhängig. Weitere Kameraeinstellungen wie Weißbalance, Übertragungscharakteristik und viele weitere haben hingegen keinen Einfluss darauf. Diese Daten werden statt dessen parallel zu den eigentlichen Bilddaten im Rohdaten-File als Zusatzinformationen mit gespeichert, so dass sie später als bevorzugte Einstellung für die Weiterverarbeitung genutzt werden können, aber nicht müssen.

In den Begleit-Daten des RAW-Bildes könnte u. a. folgendes stehen:

File Size : 14 MB

Image Width : 4640

Image Height : 3472

Bits Per Sample : 16

Compression : Uncompressed

Photometric Interpretation : BlackIsZero

Samples Per Pixel : 1

Planar Configuration : Chunky

Exposure Time : 1/8000

ISO : 200

Focal Plane Diagonal : 21.6 mm

Valid Bits : 12 0

Crop Left : 8 0

Crop Top : 8 0

Crop Width : 4608

Crop Height : 3456

Sensor Calibration : 4093 256

Aspect Ratio : 4:3

Aspect Frame : 0 0 4607 3455

Shutter Speed : 1/8000

Circle Of Confusion : 0.015 mm

RAW-Bilder erkennt man oft an ihrer Dateiendung RAW. Manche Kamera-Hersteller verwenden aber auch andere Suffixe, z. B. ORF bei Olympus, besitzen aber dennoch die standardisierte Dateistruktur eines RAW-Formats, so dass sie nicht einmal umbenannt werden müssen, um von geeigneter Software als RAW-Bilder gelesen zu werden.

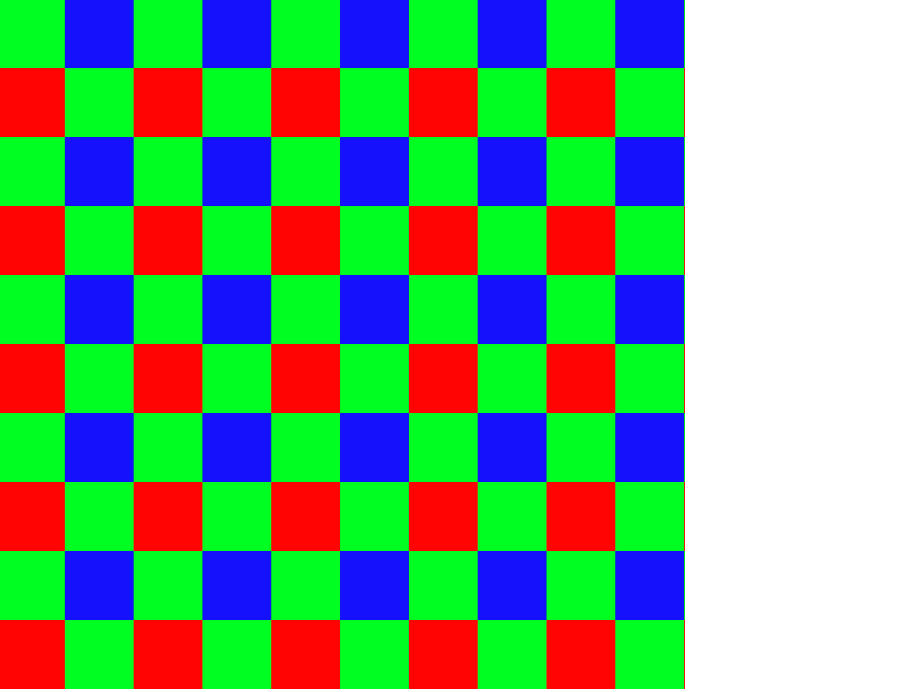

Was oft vergessen wird: Die meisten unserer Dirgitalkameras haben für Rot, Grün und Blau keine drei durchgängigen Sensorebenen, sondern bestehen aus einer Matrix von Sensorzellen, die im gleichen geometrischen Raster mit Farbfiltern der drei Grundfarben überzogen sind (Bayer-Matrix).

Die vom Sensor gewonnenen Pixel bestehen somit zu 50 % aus Grün- und je 25 % aus Rot- und Blau-empfindlichen Bildpunkten. Man erkennt hieraus das Prinzip der Farb-Unterabtastung von Rot und Blau, was dem physiologischen Empfinden angepasst ist. Die Angabe der Pixelzahl einer Kamera bezieht sich auf die Anzahl aller Pixel und teilt sich somit auf die drei Grundfarben in der oben gezeigten Weise auf. So erzeugt also eine 16-Megapixel-Farbkamera im physikalischen Sinne 8 grüne Megapixel und je 4 blaue und rote Megapixel.

Außerdem ist zu erkennen, dass keine der Farbebenen ein lückenloses Bild aufnimmt. Allgemein werden diese Lücken aber bereits vom Unschärfekreis des Objektivs verwischt. Wie gezeigt wurde, gibt also das RAW-Format die originalen Messwerte eines jeden Pixels ohne Veränderungen aus. Dabei wäre es völlig egal, ob die Sensorelemente durch eine Farbfilter-Matrix belichtet wurden oder nicht. Die Anzahl der gespeicherten Pixelwerte ist also gleich der Anzahl der Bildpunkte des Sensors: Ein 16-Megapixel-Bildsensor gibt 16 Millionen Pixelwerte aus, in aller Regel im Format von 2 Byte pro Wert, also 16 Bit. Meist entspricht die tatsächliche Messwertauflösung allerdings nicht den vollen 16 Bit, sondern z.B. nur 12 Bit.

Was eine Kamera als Rohbild-Datei (RAW-File) liefert, ist eine Datenfolge für den Belichtungswert jedes Pixels entsprechend seiner geometrischen Anordnung, ohne zunächst die Farbzugehörigkeit zu berücksichtigen. Aus diesen Daten berechnet man in einem später ausführbaren Entwicklungsprozess für jedes Kamerapixel einen vollständigen RGB-Farbwert, indem der Helligkeitswert aus den benachbarten Farbpixeln interpoliert und ergänzt wird. Diese Rekonstruktion einer farbigen Rastergrafik aus den Helligkeitswerten eines mit Mosaik-Farbfiltern überlagerten Bildsensors bezeichnet man in der Digitalfotografie als Demosaicing. Falls die Kamera so eingestellt wurde, dass sie sofort JPG- oder TIFF-Dateien speichert, erfolgt dieser Prozess natürlich sofort nach der Bildaufnahme im Bildprozessor der Kamera.

Die Farbunterabtastung vieler Videoformate ist übrigens durchaus adäquat zur Idee der Bayer-Matrix. Im weit verbreiteten Fall von 4:2:2 hätte man ebenfalls einen R- und B-Wert auf je zwei G-Werte reduziert. Zu beachten ist dass bei der Umkodierung die korrekte Behandlung der geometrischen Lage bzw. der Phase des Farb-(Differenz-)Signals sichergestellt werden muss.

Dabei kann diese Interpolation auf verschiedene Arten durchgeführt werden. Einfache Verfahren könnten den zu ergänzenden Farbwert einfach als Mittelwert aus den benachbarten Pixeln der gleichen Farbe berechnen oder die Interpolation entlang von Kanten bevorzugen. Andere könnten davon ausgehen, dass der Farbton einer Fläche im Bild auch bei sich ändernden Lichtverhältnissen relativ konstant ist, wodurch die Farbkanäle dann stark miteinander korrelieren. So würde zuerst der grüne Kanal interpoliert, um danach den roten und den blauen Kanal so zu interpolieren, dass die jeweiligen Helligkeitsverhältnisse Rot-Grün beziehungsweise Blau-Grün konstant sind. Die tatsächlich verwendete Algorithmen sind noch komplexer, für eine ungefähre Vorstellung soll das aber genügen.

Informationstechnisch handelt es sich bei jedem physikalischen Pixelwert um die so genannte Stützstelle einer analogen Funktion, die den geometrischen Verlauf der zugehörigen Grundfarbe entlang der Bildkoordinaten diskret abbildet. Würden die drei Grundfarben unabhängig voneinander betrachtet, so wäre deren maximale geometrische Auflösung nach dem Nyqist-Shannon-Abtasttheorem durch die örtliche Abtastfrequenz beschränkt. Dass die drei Farbebenen miteinander stark korrelieren, erkennt man bereits daran, dass das Motiv eines Farbbildes nach der Zerlegung in seine drei Grundfarben immer noch in jeder Farbebene gut erkennbar ist, was von der Abhängigkeit jeder Grundfarbe von der Grundhelligkeit

kommt. Diese wiederum wird am besten vom Grün-Kanal mit seinem mittleren Spektralbereich repräsentiert.

2 Die Bildentwicklung

Anscheinend ist es möglich, RAW-Bilder direkt in Schnittprogramme, wie z. B. Magix Video zu laden, was praktisch auch zu funktionieren scheint. Leider werden hierbei nicht wirklich die RAW-Daten geladen, sondern nur die darin eingebetteten JPG-Bilder, die eigentlich nur Vorschaubilder sind. Deshalb fehlen auch einige wesentliche Einstelloptionen, die man eigentlich für den Import von RAW-Bildern braucht. Angezeigt werden die importierten Bilder so, wie sie der gewählten Kameraeinstellung während der Aufnahme entsprechen. Dies gilt u. a. für den Weißabgleich und die Gradationskurve. „Ausschalten“, wie bei tatsächlichen RAW-Daten lassen sich diese Voreinstellungen logischerweise nicht. Natürlich werden auch weder die Pixelauflösung, noch die ursprüngliche RAW-Farbtiefe beim Import übergeben. Somit kann es auch keine wirklich brauchbaren Werkzeuge zur ausreichend feinfühligen und zum Teil automatisierbaren Nachbearbeitung der Aufnahmen geben.

Es gibt keinen anderen Weg, als die Einzelbilder zuerst in einem guten RAW-Entwickler zu verarbeiten und anschließend vorübergehend in ein verlustfreies Zwischenformat zu exportieren.

Weil diese Bilder nach der erfolgreichen Weiterverarbeitung zu Videosequenzen zeitnah gelöscht werden können, darf und muss man sich diese großen Datenmengen hier leisten.

Die Bildentwicklung beginnt mit dem Demosaicing, also der Trennung der Bildmatrix in die drei Farbebenen, wofür verschiedene Algorithmen angewandt werden können. Anschließend besteht das Hauptziel vor allem darin, einen natürlichen Weißabgleich zu erhalten und die Gradation, also die Belichtungskurve, zu optimieren.

Es wird eine Reihe universeller Bildentwicklungs-Anwendungen für RAW-Bilder angeboten. Auch die Kamera-Hersteller bieten hauseigene Entwickler-Software an, die vor allem oder ausschließlich Bilder aus ihren eigenen Kameramodellen verarbeitet. Allerdings ist dort der Funktionsumfang der Werkzeuge oft spärlich.

Folgende Eigenschaften waren für mich bei der Auswahl der Entwickler-Software ausschlaggebend:

– Von besonderer Wichtigkeit ist ein automatischer Durchlauf einer großen Anzahl von Bildern mit gleichem Profil im automatischen Batch-Prozess. Immerhin müssen zig-tausend Einzelbilder pro Film verarbeitet werden. Wenn bei der Entwicklung pro Filmbild 2 Sekunde gebraucht werden, so ergibt das allein für einen 10-Minuten-Film mit 24 Bildern/s schon 8 Stunden Prozesszeit! Deshalb muss der Prozess völlig selbständig ohne Interaktion ablaufen können.

– Es reicht erfahrungsgemäß nicht aus, feste Parameter für den gesamten Film vorzugeben. Es ist Flexibilität gefragt – einerseits um für einzelne Takes manuell individuelle Korrekturen komfortabel vornehmen, andererseits aber auch automatische Prozesse für jedes Filmbild ablaufen lassen zu können, die sonst einzeln gestartet werden müssten.

– Alle Interaktionen müssen ohne spürbare Wartezeiten ablaufen, während alle Zeit fordernden Vorgänge in die automatische Stapelverarbeitung gehören. Das betrifft vor allem auch die Anweisung, ein einmal gefundenes Entwicklungsprofil mit einem Schlag allen Bildern zuzuweisen, die zum gleichen Take gehören.

– Unverzichtbar ist ein hervorragend funktionierender Weißabgleich, der mit einem Auswahlwerkzeug einstellbarer Größe für graue Bildbereiche gesteuert werden kann.

– Weil es sich immer um Szenen aus zusammenhängenden Bildern handelt, sollte eine Galerie-Ansicht verfügbar sein, in der die Vorschaubilder im Zusammenhang der Szene angezeigt und ohne Wartezeiten gescrollt werden können.

– Nachbearbeitungen können – je nach dem Anspruch, den man sich stellt – in höchster Qualität oder auch als Kompromiss mit der Arbeitszeit, die man investieren möchte, ausgeführt werden. Für beide Varianten soll die Software tauglich sein.

Auch weitere Hilfsmittel für eine zügige und komfortable Arbeit sollten zur Verfügung stehen. Dies betrifft z. B. Histogramme, die die Intensitätsverteilung der Farbkanäle objektiv anzeigen, und vieles mehr.

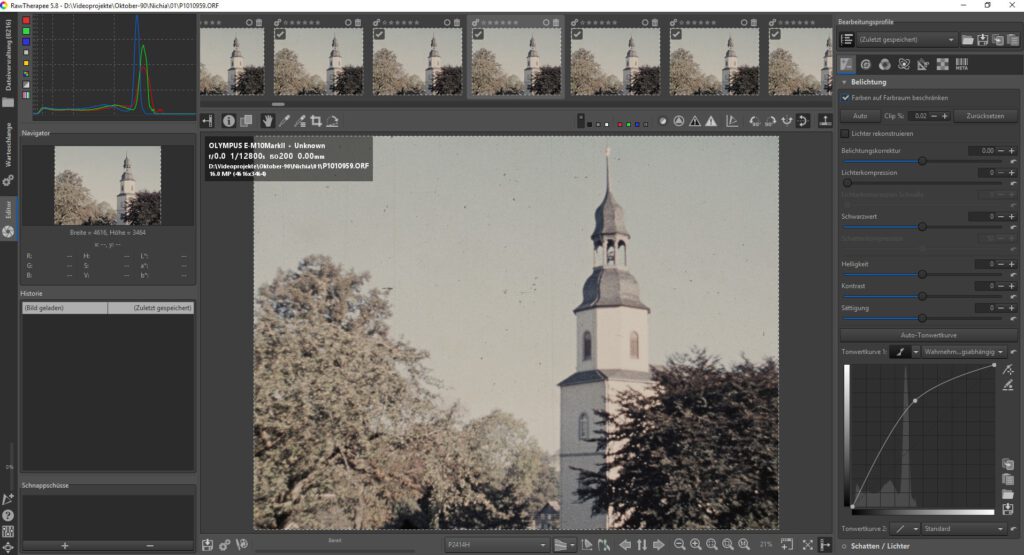

Nach vielen Experimenten und manchen Misserfolgen mit anderen Produkten entschied ich mich schließlich für die Anwendung „RawTherapee“ in der aktuellen Version 5.8, weil diese alle meine Anforderungen mit Abstand am besten erfüllt. Diese wirklich hervorragende Open-Source-Software kann kostenfrei heruntergeladen und ohne Einschränkungen oder versteckte Handicaps benutzt werden.

Ein herzliches Dankeschön an die Entwicklergemeinschaft für ein so ausgereiftes Produkt!

Link: https://rawtherapee.com/downloads

Besonders gut durchdacht und genau auf die praktischen Bedürfnisse zugeschnitten ist die Speicherung aller Einstellungen in Profilen und deren flexible Handhabbarkeit. So können nicht nur feste Werte gespeichert werden, sondern auch alle weiteren Einstellungen, wie z. B. die Anweisung, für jedes Bild (zunächst) einen automatischen Weißabgleich durchzuführen. Außerdem können Profile individuell zu jedem Bild gespeichert, auf beliebige Bilderserien übernommen oder als Standard-Bearbeitungsprofile abgespeichert und beliebig angewendet werden.

Wenn ich in dieser großartigen Anwendung überhaupt etwas vermisse, dann ist es die fehlende Verwendung des Grafikprozessors (GPU), der zur Beschleunigung der Bildberechnungen dienen könnte. Das kann ich aber gut verschmerzen, weil diese Berechnungen ohnehin ohne mein weiteres Zutun im automatischen Batch-Prozess ablaufen.

Nachfolgend werden alle Schritte und Einstellungen beschrieben, die ich als wesentlich für die Entwicklung der Filmbilder mit „RawTherapee“ betrachte. Natürlich sind diese auch variierbar und weiter ausbaufähig.

Es ist dringend zu empfehlen, ja unbedingt notwendig, vorher zumindest eine erste Einführung in die Programmoberfläche zu lesen und sich näher mit dem Programm vertraut zu machen, bevor man beginnt, damit zu arbeiten:

http://rawpedia.rawtherapee.com/Getting_Started/de

http://rawpedia.rawtherapee.com/Main_Page

Anderenfalls würde man wenig Freude damit haben, weil man die Grundlagen nicht versteht.

2.1 Die Grundeinstellungen

![]() Nach dem Programmstart von „RawTherapee“ erscheint am linken Bildrand im unteren Bereich ein Button „Einstellungen“ mit dem ein Fenster mit vielen Reitern geöffnet wird.

Nach dem Programmstart von „RawTherapee“ erscheint am linken Bildrand im unteren Bereich ein Button „Einstellungen“ mit dem ein Fenster mit vielen Reitern geöffnet wird.

Ausgehend von den Standardeinstellungen sind nur wenige Einträge zu ändern:

Bildbearbeitung/

Standard-Bearbeitungsprofile/

Für RAW-Dateien: [Jeweils bevorzugtes eigenes Profil]

Hier kann man ein Standard-Bearbeitungsprofil eintragen, mit dem jedes neu geladene RAW-Bild zunächst behandelt wird (vergl. 2.9). Bitte erst eintragen, nachdem ein solches definiert wurde.

Bildbearbeitung/

Behandlung der Bearbeitungsprofile/

Speicherort der Profile:

Bearbeitungsprofile im Festplattencache speichern

Hierdurch werden die Wartezeiten minimiert, wenn vordefinierte Profile auf eine Bildfolge angewandt werden. Damit wird nicht jedem Einzelbild eine Profildatei zugeordnet, was in der praktizierten Arbeitsweise auch überhaupt nicht nötig ist.

Dateiverwaltung/

Bildinformationen und Miniaturbilder/

Datum und Uhrzeit anzeigen → aus

Exif-Daten anzeigen → aus

Diese Optionen auszuschalten wird empfohlen, weil sie für unseren Zweck unnötig sind, aber Bildschirmfläche beanspruchen.

Farbmanagement/

Monitor/

Standardfarbprofil: z. B. P2414H

Hier sind die Farbprofile von Monitor und ggf. auch Drucker einzustellen. Für viele Geräte werden die Profile vom Hersteller bereitgestellt.. Oft entsprechen diese den Systemeinstellungen.

Alle weiteren Einträge können unverändert bleiben.

2.2 Demosaicing

Sofern die Kamera einen Sensor mit Bayer-Matrix enthält – es gibt nur wenige Kameramodelle, wo das nicht zutrifft – empfiehlt es sich, als Methode AMaZE auszuwählen. Alle übrigen Einstellparameter wird man in der Standardeinstellung belassen können.

2.3 Geometrische Korrekturen

![]() Je nach Filmlauf im Projektor ist das aufgezeichnete Bild oft spiegelverkehrt oder auch kopfüber verdreht aufgezeichnet worden. Wenn der Film durch den umgebauten Projektor ebenso abläuft wie sonst und die Kamera von vorn aufrecht stehend an die Filmbühne angebaut ist, so ist das Kamerabild vertikal, also an der waagerechten Mittellinie, zu spiegeln, was über den oben gezeigten Button geschieht. Andere Projektionsgeometrien können andere geometrische Korrekturen erfordern. Läuft hingegen eine Positivkopie rückwärts durch den Projektor, um von der Emulsionsseite kopiert zu werden, so ist überhaupt keine Korrektur nötig.

Je nach Filmlauf im Projektor ist das aufgezeichnete Bild oft spiegelverkehrt oder auch kopfüber verdreht aufgezeichnet worden. Wenn der Film durch den umgebauten Projektor ebenso abläuft wie sonst und die Kamera von vorn aufrecht stehend an die Filmbühne angebaut ist, so ist das Kamerabild vertikal, also an der waagerechten Mittellinie, zu spiegeln, was über den oben gezeigten Button geschieht. Andere Projektionsgeometrien können andere geometrische Korrekturen erfordern. Läuft hingegen eine Positivkopie rückwärts durch den Projektor, um von der Emulsionsseite kopiert zu werden, so ist überhaupt keine Korrektur nötig.

Solche Korrekturen gehen blitzschnell, weil dazu nicht die ganze Datei umstrukturiert werden muss, sondern nur ein Eintrag (Tag) in der Datei verändert wird.

Eine Bildbegrenzung von den Rändern her sollte man erst später mit der Rohsequenz ausführen – selbst dann, wenn sich in den Einzelbildern der Rand der Filmbühne oder Fusseln an den Bildrändern abbilden. Es könnte z. B. später nötig werden, zusätzliche Randbereiche der Bildstabilisierung zu opfern oder künstliche Kamera- und Zoombewegungen einzufügen, wofür dann gewisse Reserven gebraucht werden. Gerade für solche Korrekturen bietet dann auch das vorgesehene Oversampling der Pixelauflösung genügend Spielraum.

Sonstige geometrische Korrekturen, z. B. von Objektiv-Verzeichnungen, sollten möglichst nicht erforderlich sein. Falls aber doch, werden auch dafür sehr feinfühlige Werkzeuge von dieser Anwendung angeboten.

2.4 Der Weißabgleich

Der Weißabgleich dient dazu, die Farbwiedergabe der Bildobjekte so natürlich wie möglich erscheinen zu lassen. Wäre man während der Bildaufnahme in der Lage gewesen, Farbnormtafeln mit aufzuzeichnen, so könnte mit deren Hilfe im Nachgang eine sehr exakte Bildentwicklung erfolgen. In unserem Fall sind aber die Aufnahmen längst erfolgt, vielleicht vor Jahrzehnten, ohne dass solche Hilfsmittel im Filmbild verfügbar sind. Statt eines durchgängig anwendbaren Farbmanagements liegt in der Übertragungskette ein Film mit seinen weitgehend unbekannten und nicht konstanten Übertragungsfunktionen. Schließlich gab es ja früher auch unterschiedliches Filmmaterial für Tages- und Kunstlicht, das man erstens nicht einfach auf Knopfdruck austauschen konnte und das auch nicht für jede Farbtemperatur erhältlich war. Gut, man konnte Konversionsfilter benutzen, aber auch diese waren eigentlich ein Kompromiss. Es gibt deshalb durchaus auch sehr rot-stichige Kunstlicht- und blau-stichige Tageslichtaufnahmen im Filmarchiv, die sich sehr effektiv und fast ohne Restfehler korrigieren lassen. Erfahrungsgemäß muss aber praktisch an jeder Aufnahme korrigiert werden. Wie soll man nun aus einem solchen „Nudeltopf“ eine ausgewogene natürliche Farbwiedergabe zurückgewinnen?

Am Versuch, die Farben mit Hilfe verschiedenster Farbregler oder über die Einstellung der Farbtemperatur nachzugleichen, bin ich kläglich gescheitert. War ich nach langen Versuchen mit den Ergebnissen soweit zufrieden, musste ich am nächsten Tag schon wieder daran drehen. Mag sein, es gibt Spezialisten, die das besser können. Ich betrachte diese Arbeitsweise aber schon wegen des Zeitaufwands als nicht praktikabel. Daran ändert sich auch nichts, wenn dieser Abgleich szenenweise erfolgt und einmal optimierte Profile für

ähnliche Aufnahmeverhältnisse wiederverwendet werden können.

Der automatische Farbabgleich, der das gesamte Bild auswertet, liefert bereits versöhnliche Ergebnisse und kann für die Produktivität ein Segen sein. Muss man einmal schnell fertig werden, könnte man sich damit auch zufrieden geben. Oft sind jedoch noch bessere Ergebnisse erzielbar.

Im Hinblick auf einen möglichst nicht ausufernden Arbeitsaufwand beim Postprozess und anhand sehr ordentlicher Ergebnisse, die sich damit erzielen lassen, habe ich mich für den halbautomatischen Weißabgleich in RawTherapee entschieden. Die dabei erreichten Ergebnisse konnte ich durch manuellen Abgleich nicht wirklich übertreffen und sie sind weitgehend unabhängig von subjektiven Entscheidungen oder Müdigkeit. Ein großartiges Werkzeug ist dafür der Farbwähler.

Für eine objektive Farbkalibrierung steht uns ja nicht viel mehr zur Verfügung, als im Bildinhalt auffindbare (vermeintlich) graue Flächen unterschiedlicher Helligkeit. Alle anderen Farben und Nuancen könnten nur im Blindflug angepasst werden. Weil man nun aber nicht jede im Bild vorhandene Farbe nachjustieren kann, besteht der Lösungsansatz in folgender Überlegung: Unbunte Objekte im Bild, also solche, die ein reines Grau ohne Farbnuancen verkörpern, können nur dann auch grau wiedergeben werden, wenn jede der drei Grundfarben in diesem Arbeitspunkt den gleichen Wert enthält.

Ein Beispiel: Hätte bei einer 8-Bit-Farbtiefe, die einen Wertebereich von {0 … 255} wiedergibt, jede RGB-Farbe den gleichen Wert 127, so wäre das ein mittelheller unbunter Grauwert. Für das RGB-Triple wäre als Vektor zu schreiben (127, 127, 127). Hätte er hingegen den Wert von z. B. (126, 126, 130), so hätten wir einen mittelhellen Grauwert mit leichter Blauverfärbung. Wissen wir aber, dass die tatsächliche Farbe dieser Objektfläche neutral grau oder weiß war, so müssten die Übertragungskurven der einzelnen Farben so korrigiert werden, dass im Ergebnis in diesem Punkt die drei Farbwerte einander gleich sind. Am besten wäre es also, man könnte eine neutral weiße Fläche als Folge unterschiedlicher Belichtungswerte abbilden, die sich zueinander linear verhalten (tatsächlich ist das eine quadratische Funktion der Verschlusszeiten), so dass sich eine Folge von Grauwerten ergibt.

Die Übertragungsfunktionen des Rot-, Grün- und Blau-Kanals werden nun so angeglichen, dass sie in den Messpunkten die entsprechend abgestuften aber stets zueinander gleichen Werte ergeben. Auch gleichzeitig vorhandene Grau-Schattierungen im Objekt könnten in einem gemeinsamen Bild beinahe die gleiche Funktion ermöglichen.

In natürlichen Objekten, die bereits auf einem Film abgebildet sind, ist es jedoch schwierig, abgestufte Grauwerte zu finden. Manchmal ist nicht einmal ein einziger Grauwert vorhanden. Ein solcher Grauwert darf auch nicht gesättigt weiß sein, weil dann der lineare Bereich von wenigstens einem Farbkanal verlassen worden wäre und keine lineare Auswertung mehr möglich ist.

Die praktikable Arbeitsweise kann deshalb nur darin bestehen, mit der „Pipette“ des Farbwählers einen kleinen Bildausschnitt auszuwählen, den man als unbunt erwartet, der also im Original weiß oder neutral grau war. Obwohl es eigentlich schon abenteuerlich ist, aus den Messwerten eines einzigen Bildpunktes die Farben eines ganzen Bildes nachzugleichen, sind doch die erzielbaren Ergebnisse erstaunlich gut. Eine wichtige Voraussetzung, dass dies funktionieren kann, ist eine möglichst lineare Übertragungskurve für alle Farben bei allen Stationen der Bildaufzeichnung und Digitalisierung. Wie sich in der Praxis zeigt, wird diese Forderung von fotografischen Emulsionen auf unseren Filmen sogar dann erfüllt, wenn ihre Charakteristik nicht mit der Beleuchtung übereinstimmte. Das Beispielbild zeigt eine unkorrigierte Kunstlichtaufnahme mit Tageslichtfilm. Man erkennt den ausgeprägten Rotstich. Nach der halbautomatischen Farbkorrektur für einen manuell ausgewählten Grauwert erhält man eine ausgewogene Farbwiedergabe.

Dieses Ergebnis wurde nach wenigen Click-Versuchen mit der Graupunkt-Pipette erzielt und ist für alle Bilder der Szene direkt anwendbar. Oft kann die gleiche Einstellung auch für weitere Szenen, die unter gleichen Bedingungen entstanden, angewendet werden.

Damit das wirklich klappt, darf es bei der Digitalisierung nicht zu größeren Nichtlinearitäten bei der Aufteilung auf die Farbkanäle kommen. Deshalb ist eine spektral ausgewogene Kopierbeleuchtung sehr wichtig, so wie im Teil „Die Filmabtastung“ Kapitel 2 für die Lichtquelle beschrieben wurde. Es konnte experimentell nachgewiesen werden, dass mit LED-Lichtquellen, die keinen klassifizierten CRI ausweisen, keine adäquaten Ergebnisse bei der Farbwiedergabe möglich waren.

Für die Auswahl des unbunten Bildbereichs muss man die Größe der Pipette so einstellen, dass eine repräsentative Pixelauswahl möglich ist. Ist sie zu klein, so spielt das Bildrauschen eine zu große Rolle und die Ergebnisse variieren stark bei mehrfacher Auswahl des vermeintlich gleichen Bildbereichs. Ist sie hingegen zu groß, so können kleine Bildbereiche nicht selektiert werden. Eine Größe von 16×16 Pixeln ist erfahrungsgemäß optimal und erlaubt die Auswahl auch kleiner Bildbereiche, führt aber dennoch zu stabilen Ergebnissen.

Ist man mit dem Ergebnis nicht gleich zufrieden, so hilft es oft, die angewählte Bildposition leicht zu variieren oder eine weitere zu versuchen. Immerhin erlaubt es die Software, das Ergebnis jeweils augenblicklich betrachten und bei Bedarf wiederholt korrigieren zu können.

An dieser Stelle muss erwähnt werden, dass eine verlässliche Beurteilbarkeit des Weißabgleichs voraussetzt, dass die Prozesskette bis hin zum Monitor mittels einer Profildatei farbkalibriert ist. Im einfachsten Fall benutzt man dazu die vom Monitorhersteller bereitgestellte Profildatei für den verwendeten Monitortyp. Exemplarische Gerätestreuungen und Alterungsprozesse werden damit aber nicht ausreichend korrigiert. Besser ist es deshalb, die Farbübertragung in periodischen Zeitabständen kolorimetrisch zu korrigieren, wofür geeignete Kolorimeter angeboten werden, die man für den Messprozess direkt am Monitor anbringt. Hat man die Möglichkeit, solche Messungen vorzunehmen, sollte auch die Vorführtechnik wie Fernseher oder Beamer auf gleiche Weise kalibriert werden.

Auch spielt das Umgebungslicht bei jeder Betrachtung eine wichtige Rolle. Mit Normlicht zu arbeiten, wird allgemein nicht möglich und nicht nötig sein. Statt dessen arbeitet man am besten bei gedämpftem Umgebungslicht.

Bei aller Farbkorrektur darf man einen Aspekt nicht übersehen: Bei einer automatischen oder halbautomatischen Weißbalance können auch ursprünglich vorhandene oder gewollte Farbstimmungen verloren gehen. Hier muss dann bei Bedarf doch noch manuell eingegriffen werden, wenn man nicht nur emotionsfreie Filmberichte, sondern auch künstlerisch gestaltete Filme bearbeitet. Auch hierfür bietet die genannte Software sehr gute Werkzeuge an. Kleinere Nuancen von Farbverschiebungen können außerdem auch später noch in der Filmsequenz nachgeglichen werden.

2.5 Die Korrektur der Gradation

Mit der Belichtung und Gradation ist es ähnlich wie beim Weißabgleich: Auf eine Automatik sollte man sich nicht verlassen, weil die Einzelszenen zu individuell sind. Deshalb wird man stets manuell und subjektiv abgleichen müssen.

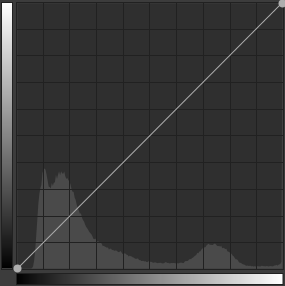

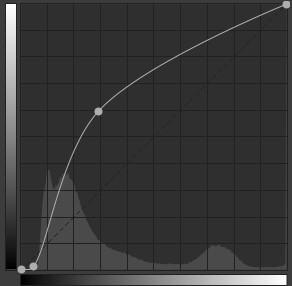

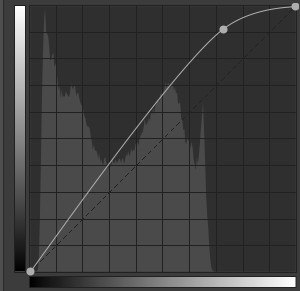

Ein wichtiges Hilfsmittel ist neben der Bildanzeige das grau dargestellte Helligkeits-Histogramm des Originals im Hintergrund.

Von links nach rechts wird die Helligkeit von Schwarz bis Weiß dargestellt (deshalb der dargestellte Graukeil als Abszisse), während die Amplitude die Häufigkeit anzeigt, mit der die jeweilige Helligkeit in den Pixeln auftritt (hiermit hat der Graukeil als Ordinate allerdings nichts zu tun). Man sieht also ein Säulendiagramm mit einer sehr großen Anzahl von Säulen, die in der Anzeige als durchgängige Fläche dargestellt wird. Für eine Farbtiefe von 8 Bit hätte man 256 Säulen, für 12 Bit sogar 4096. Bestünde ein Bild selbst gänzlich aus einem linearer Graukeil, der sich von einer Bildkante zur gegenüber liegenden erstreckte, so hätte das Histogramm über seine gesamte Breite hinweg eine konstante Höhe. Ein Graubild mit konstanter Helligkeit in allen Pixeln würde hingegen eine senkrechte Linie an der jeweiligen Helligkeitsposition erzeugen.

In diesem Beispiel ist ein „Gebirge“ zu sehen, das etwas heller als bei Schwarz beginnt, dann seine Hauptanteile im untersten Helligkeits-Drittel besitzt und nach oben hin nach einer kleineren Welle ausläuft. Im gleichen Diagramm wird außerdem die eingestellte Übertragungsfunktion, auch Gradation

oder Gammakurve genannt, dargestellt.

Zu ihr gehört die Graukeil-Skale, die am linken Rand nach oben verläuft. Die Gradation zeigt die Zuordnung der Helligkeit im Ergebnis-Bild zur jeweiligen Helligkeit im Original. Eine gerade diagonale Linie wie hier bedeutet, jeder Grauwert wird unverändert, also 1:1 übernommen.

Die Endpunkte lassen sich in der Anwendung mit der Maus anfassen und verschieben. Um einen nichtlinearen Verlauf der Gradationskurve festlegen zu können, kann man beliebig viele weitere Verlaufspunkte setzen und verschieben.

Hier wurde die Übertragungsfunktion mit zusätzlichen Punkten versehen, wodurch die Steilheit im Bereich der größten Graustufen-Dichte erhöht wurde. Der dunkle Anfangsbereich, der ohnehin keine Bildinformationen enthält, wurde stark komprimiert und der in Richtung Weiß auslaufende Bereich mit einer allmählich abfallenden Steigung versehen.

Als allgemeine Regel für die Übertragungsfunktion könnte gelten, dass in Bereichen hoher Histogrammwellen die Steilheit der Kurve größer sein sollte, als in Bereichen kleinerer Wellen. Hierdurch werden eng nebeneinander liegende Grau- oder Farbwerte auseinander gezogen, während weiter verteilte komprimiert werden. Diese Regel soll aber nur eine Orientierung sein. Entscheidend ist das Ergebnis im Bild, das stets ohne Wartezeit als Vorschau angezeigt wird.

Dieses Beispiel zeigt eine häufig anzutreffende Helligkeitsverteilung: Ein ausgewogenes Histogramm mit natürlichen Schwankungen, aber hauptsächlich im dunkleren Aussteuerbereich präsent. Das obere Drittel scheint nicht ausgesteuert zu werden. Tatsächlich gibt es aber Bildpartien mit solchen Helligkeitswerten. Verschiebt man den oberen Endpunkt nach links in die Nähe der scheinbar oberen Histogramm-Grenze, so würden dem Bild Details in den Lichtern fehlen. Hier hat sich im Hauptbereich ein versteilerter linearer Anstieg bewährt, der nach oben flacher ausläuft.

Übrigens gibt es auch die Möglichkeit, einen Schwarz- und einen Weißpunkt mithilfe von Schwarz- und Weißbildern zu definieren. Hierbei könnte man die kleinste und die größte auftretende Helligkeit über Referenzbilder erfassen und der Software übergeben, um damit den Übertragungsbereich zu spreizen. Vorstellbar wäre das auch bei Filmkopien; man könnte dafür Schwarzfilm und Weißfilm einzeln kopieren? Nein – mit einer automatischen Belichtungsregelung im Kopierprozess funktioniert das natürlich nicht.

2.6 Die Farbsättigung

Gegenüber unseren heutigen Erfahrungen mit modernen Digitalkameras wirken die kopierten Filme zuweilen etwas blass. Dieser subjektive Eindruck wird noch verstärkt, wenn die Bilder mit Korn, Staub und Rauschen überlagert sind. Ein vorsichtiges Anheben der Farbsättigung kann die Bilder dynamischer wirken lassen, wenn dies wohldosiert geschieht.

Anstelle des Reglers ‚Sättigung‘ empfiehlt es sich, die CC-Kurve in den Lab-Anpassungen zu editieren, wodurch die Farbbrillanz etwas gewinnen kann. Diese und weitere Einstellungen finden sich unter ‚Belichtung‘, sollen hier aber nicht vertieft werden. Es sei ein weiteres Mal auf die Programmdokumentation verwiesen.

2.7 Professioneller Kinolook?

Bei Spielfilmen ist es Tradition, Farbabgleich und Gradation nicht nur nach objektiven oder physikalisch korrekten Kriterien zu wählen, sondern mit bestimmten Stimmungen zu versehen. Dies mag auch für den Amateur interessant sein, wenn er Spielfilme dreht. Die aus technischer Sicht beste Gelegenheit für solche speziellen „Tönungen“ bietet sich hier bei der Bildentwicklung an, wo noch eine ausreichend hohe Bitauflösung der Farbkanäle vorhanden ist.

Ich halte es für empfehlenswert, zuerst eine möglichst natürliche Farbwiedergabe und -gradation zu erhalten, so wie beschrieben, und diese in 16-Bit-TIFF-Bildern zwischenzuspeichern. Erst anschließend sollte man auf dieser Basis mit einem speziellen Look experimentieren, was auch in einigen Videoschnittprogrammen bei 10 Bit oder 12 Bit Farbtiefe möglich ist.

2.8 Profile kopieren und einfügen

Hat man nun für ein Einzelbild einen guten Abgleich gefunden, so lässt er sich oft auf die gesamte Sequenz oder sogar auf weitere (benachbarte) Sequenzen anwenden. Hierzu gibt es zwei Methoden:

1) Copy & Paste: Nachdem die Einstellung für ein Einzelbild, also das Profil, festliegt, wird im File Browser oder im Filmstrip mit der rechten Maustaste auf das Vorschaubild geclickt und im lokalen Menü ‚Profiloperationen/Profil kopieren‘ gewählt. Das Profil befindet sich danach in einer Zwischenablage. Um dieses Profil auf andere Bilder anzuwenden, werden diese in üblicher Weise angewählt, dann auf eines davon mit der rechten Maustaste geclickt und im lokalen Menü ‚Profiloperationen/Profil einfügen‘ gewählt.

2) Sync: Es werden im File Browser einfache feste Einstellungen auf die Bilder angewendet.

2.9 Ein Standardprofil

Die Arbeit an den Einzelbildern geht besonders flüssig von der Hand, wenn jedem neu zu editierenden Bild schon beim Laden ein annähernd passendes Standardprofil zugewiesen wird. Es hat sich gezeigt, dass bei gleichem Filmmaterial und natürlich gleicher Scan-Apparatur immer wieder ähnliche Korrekturen erforderlich sind. So reduziert sich die Arbeitszeit erheblich, wenn man sich auf wenige individuelle Korrekturen beschränken kann.

2.10 Die Berechnung in der Queue (Auftragsstapel)

Die Queue ist ein äußerst wichtiges Instrument zur Rationalisierung aller Arbeiten in Raw-Therapee. Hier werden alle Berechnungsaufträge abgelegt und können entweder im Hintergrund abgearbeitet werden, während man schon weiter arbeitet oder auch dann, wenn man gerade nicht arbeitet. Letzteres ist meine bevorzugte Arbeitsweise, denn es kommt natürlich zu einer hohen Grundauslastung der CPU während der Hintergrundaktivitäten.

Die Handhabung ist äußerst einfach: Nachdem die Einstellungen für Einzelbilder oder ganze Bilderserien (Szenen) festgelegt wurden, werden sie in die Queue gestellt. Das Starten und bei Bedarf auch das Unterbrechen oder Abbrechen der Stapelverarbeitung erfolgt manuell, so dass man alles selbst bestimmen kann.

Interessant und wichtig ist, dass die Aufträge in der Queue persistent sind. Das heißt, sie bleiben auch dann erhalten, wenn das Programm zwischendurch geschlossen wird oder gar abstürzt (was mir aber noch nie passiert ist). Erst wenn die Aufträge erfüllt sind, werden sie automatisch gelöscht.

2.11 Nicht gelöste Probleme

Für folgende Besonderheiten konnte ich bisher keine Lösungen finden:

Belichtungs- und Farbschwankungen im Filmmaterial, z. B. bei angelichteten oder fehlentwickelten Filmlängen. Weder eine individuelle Einzelbildbearbeitung, noch die Verwendung von automatischen Werkzeugen führte bisher zum Erfolg. Die einzige Möglichkeit, solche Fehler zu kaschieren, könnten spätere Tricks mit der Rohsequenz im Filmeditor sein.

2.12 Aufräumen zum Schluss!

Hat man ein Projekt so weit abgeschlossen, dass die Rohsequenz erzeugt ist und auf Fehlerfreiheit überprüft wurde, darf man nicht vergessen, die Festplatten von nicht mehr benötigtem Datenmüll zu befreien. Neben den vielen und großen Einzelbild-Dateien, die man nicht mehr braucht, hat auch „RawTherapee“ Spuren hinterlassen. Die „Spülung“ kann man ganz einfach ziehen, indem unter „Einstellungen“ der Cache gelöscht wird:

Dateiverwaltung/

Alle Dateien im Zwischenspeicher löschen

3 Über die Bilddatenkompression und das Zielformat

Man unterscheidet zwischen verlustfreier und verlustbehafteter Komprimierung.

Die verlustfreie Komprimierung verringert den Datenumfang, indem die enthaltenen Informationen anders strukturiert, miteinander kombiniert oder auf andere Weise optimiert werden. Nach einer Rückwandlung einer solchen Datei ist sie wieder vollständig rekostruiert und weist keinerlei Unterschiede zum Original auf. Als Beispiel aus der allgemeinen Datenwelt sind die ZIP-Dateien bekannt, für Bilddateien seien komprimierte TIFF-Dateien und PNG-Dateien genannt. Der erreichbare Kompressionsfaktor ist stark vom Dateninhalt abhängig.

Ein verrauschtes ungefiltertes Bild ist beinahe gar nicht komprimierbar, eine einfache Computergrafik hingegen fast zu 100 %. Der Kompressionsfaktor bei natürlichen Digitalfotos liegt erfahrungsgemäß im niedrigen einstelligen Bereich.

Wesentlich größere Faktoren werden mit verlustbehafteter Kompression erreicht, wie von JPG-Bildern gut bekannt. Es gilt der allgemeine Zusammenhang, dass eine höhere Kompression mit größeren Verlusten der Bilddetails bzw. mit ungewollten Bildartefakten einher geht.

Ein weiterer Kostenfaktor ist der Kodier- und Dekodieraufwand, bzw. die Prozessorzeit.

Mit modernen Kodieralgorithmen und leistungsfähigen Prozessoren sind sehr ansehnliche Kompromisse zwischen Kompression und Informationsverlusten möglich. Oft sind Bildfehler nur an größeren regelmäßigen Bildinhalten erkennbar, z. B. an geraden Objektkanten. Problematisch kann es aber werden, wenn Komprimierungen und Dekomprimierungen nicht nur einmalig sondern mehrfach nacheinander in einer Verarbeitungskette auftreten und dabei vielleicht sogar mit unterschiedlichen Algorithmen arbeiten.

Wie später noch gezeigt wird, muss auch der Videofilm, der aus den Einzelbildern entsteht, wenigstens noch einmal verlustbehaftet komprimiert werden. Deshalb soll in der Phase der Einzelbilder keine verlustbehaftete Komprimierung zugelassen werden, zumal diese Dateien nur temporär gebraucht werden und später gelöscht werden können. So ist der vorübergehend höhere Speicheraufwand von untergeordneter Bedeutung. Die Verwendung einer verlustfreien Kompression führt bei Filmkopien wegen der Gradation nur zu geringfügig kleineren Dateien, erhöht aber die Prozessorzeit erheblich und ist deshalb nicht zu empfehlen.

Für den Export der Einzelbilder wird das unkomprimierte TIFF-Format verwendet.

4 Der TIFF-Export

4.1 Überlegungen zur Pixelauflösung

Es bietet sich an, die volle Bildauflösung der Kamera auch für die weitere Verarbeitung zu nutzen. Das 14-Megapixel-Bild einer MFT-Kamera hätte da schon eine Zeilenzahl von 3456, größere Kameras auch noch mehr. Dies käme schon in die Nähe von Ultra-HDTV-2 mit 4320 Zeilen und scheint damit sehr komfortabel zu sein – wirklich?

Zu bedenken ist, dass unser originales Filmbild zwar viel mehr kann, als etwa eine S-VHSAufnahme, jedoch stets Unschärfen und das bekannte Filmkorn mitbringt. Andererseits haben hohe Bildauflösungen auch zur Folge, dass sich der benötigte Speicherplatz aufbläht und die Bearbeitungszeiten zum Problem anwachsen.

Bei der Diskussion über eine sinnvolle Auflösung geht es hier aber nicht um das vorführbereite Video, sondern um ein Zwischenformat, das noch weitere Nachbearbeitungen wie Ausschnittsvergrößerungen, eventuell auch wegen notwendiger Bildstabilisierung, und verschiedenste Filterprozeduren erfahren soll. Da wäre es doch von Vorteil, anfangs mit einer Überabtastung (Oversampling) zu arbeiten. Moderne Rechentechnik kommt mit solchen Auflösungen ja problemlos zurecht.

Anderenfalls sollte man die im Ausgangsbild vorhandenen Informationsinhalte auch nicht künstlich aufpumpen. Kann man nun die spatiale Abtastfrequenz, also die übertragene Bildauflösung, reduzieren, ohne einen merklichen Informationsverlust zu erleiden?

Aus der Sicht des Kamerabildes könnte man vereinfacht so herangehen:

1) Es wird angenommen, dass die Interpolation der Rot- und Blau-Zwischenbilder maßgeblich auf dem geometrischen Verlauf der Helligkeit beruht.

2) Die hauptsächliche Helligkeitsinformation ist im Grün-Kanal und damit in der Hälfte aller gewandelten Pixelwerte enthalten.

3) Schlussfolgernd ist bei einer Reduktion der Bildauflösung auf die originale Pixelauflösung des Grünkanals kein signifikanter Informationsverlust zu erwarten.

4) Hieraus ergibt sich eine sinnvolle Reduktion der zu übertragenden Pixelzahl auf die Hälfte der physikalischen Pixel, was einer Reduktion der linearen Auflösung mit dem Faktor 0,707 entspricht. Daraus wird geschlussfolgert, dass eine Reduktion der linearen RGB-Bildauflösung auf ca. 70 % der Rohbildauflösung keinen signifikanten Informationsverlust zur Folge haben wird.

Rechenbeispiel: Die Kamera Olympus E-M10 II liefert ein RAW-Bild der Größe 4608 x 3456 Pixel. Dieses könnte hiernach ohne zu erwartende Informationsverluste rechnerisch auf ein RGB-Bild mit der Auflösung von 3258 x 2444 reduziert werden.

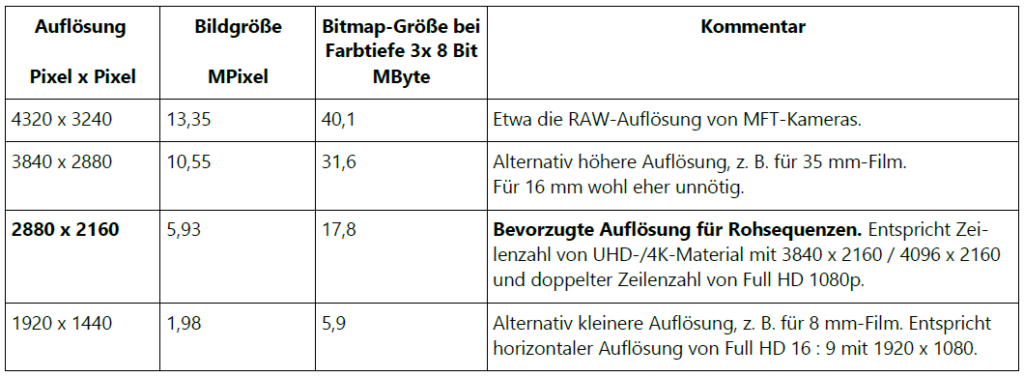

Als Ausgangsmaterial für die nachfolgende Filmbearbeitung entschied ich mich für eine bevorzugte Auflösung von 2880 x 2160 Pixeln. Will man mit etwas kleinerer Auflösung arbeiten, so würde sich ein Format mit 1920 x 1440 Pixeln anbieten. Damit betrüge die lineare Auflösung der RGB-Pixel immerhin noch 83 % der Originalauflösung der Grün-Pixel und 167 % der Rot- und Blau-Pixel, wobei sich die Gesamtzahl der zu speichernden Pixelwerte deutlich reduzierte – und dies bei einem immer noch tragbaren technischen Kompromiss.

In der folgenden Tabelle sind einige, in die engere Wahl kommende, Pixelauflösungen für

das Bildseitenverhältnis 4:3 zusammengestellt.

Aus Sicht des Filmbildes konnte ich beim sorgfältigen Betrachten von Vergleichsbildern aus 16 mm-Kopien zwischen 1920 x 1440 Pixeln und der doppelten linearen Auflösung kaum zusätzliche Bildinformationen feststellen. Natürlich ist das abhängig von der Schärfe des Ausgangsmaterials und den optischen Eigenschaften des verwendeten Filmscanners. Lassen wir also „die Kirche im Dorf“ und verwenden dennoch einen guten Oversampling-Faktor:

Für den Export der Schmalfilm-Bilder für die Rohsequenzen wird eine Ziel-Auflösung von

2880 x 2160 empfohlen.

Alternativ kann auch die kleinere Auflösung von 1920 x 1440 Pixeln ausreichen, insbesondere für Ausgangsmaterial im 8 mm-Format.

4.2 Notwendige Farbtiefe

Bei der „Entwicklung“ der RAW-Bilder mithilfe Hersteller-eigener oder fremder Software erfolgt das Demosaicing, das mit der Neuberechnung des RGB-Triples für jede Pixelposition verbunden ist. Solche Berechnungen unter Beteiligung von Multiplikationen und Divisionen mit Fließkommazahlen führen stets zu „Nachkommastellen“ der ursprünglichen Ganzzahlwerte. Hieraus ergeben sich feinere Diskretisierungsstufen, so dass eine höhere Farbtiefe als die der Ausgangsdaten möglich ist. Wird also im Ergebnis ein TIFF-Bild mit einer Farbtiefe von 3×16 Bit = 48 Bit erzeugt, so wird diese auch vollständig mit 16 Bit pro Farbe ausgenutzt, wie Testergebnisse bestätigten.

5 Rohsequenzen erzeugen

Unter Rohsequenzen sollen jene Videosequenzen verstanden werden, die unmittelbar aus den Einzelbildern entstehen. Eine wesentliche Frage, die zuerst zu beantworten ist, betrifft den zu verwendenden Codec und das Datei- bzw. Containerformat.

Für eine Kontrolle der Mediendaten empfiehlt sich das Tool MediaInfo:

https://mediainfo.sourceforge.net

6 Die Sonderbehandlung von fehlerhaftem Filmmaterial

In der Praxis kommt es vor, dass unser Ausgangsmaterial bestimmte Fehler hat. Nachfolgend wird in einem Beispiel aufgezeigt, wie solche Fehler korrigiert werden können. Nicht immer werden sie damit vollständig beseitigt, wenigstens aber in ihrer störenden Wirkung deutlich reduziert. Da sich der vorliegende Teil mit der Rohbildverarbeitung befasst, sollen hier auch nur solche Maßnahmen beschrieben werden, die sich bevorzugt in dieser Etappe beeinflussen lassen.

6.1 Filmtransportfehler

In diesem Bild veränderte sich die Position des Films in der Bildbühne während der Belichtung. Dies ist daran zu erkennen, dass alle Objekte vertikale Unschärfen aufweisen. Als mögliche Ursachen kommen neben grundlegenden Problemen der Kameramechanik auch Verschmutzungen des Greifers und Perforations- oder Abmessungsfehler des Filmmaterials in Betracht.

Im gezeigten Beispiel beschränkten sich solche Fehler auf wenige Sequenzen eines Films und dort auf eine begrenzte Anzahl Bilder (nun ja, es waren insgesamt immerhin 98 Stück!). Die so beschädigten Einzelbilder sind nicht mehr zu retten, das ist klar. Wenn man aber Glück hat, sind die benachbarten Bilder intakt, so wie im vorliegenden Beispiel. So bietet es sich an, je ein Bild durch ein benachbartes einfach zu ersetzen. Hierbei wird stets konsequent entweder das vorhergehende oder das nachfolgende Bild verwendet. Nur dann, wenn wirklich einmal zwei oder mehr aufeinander folgende Bilder ersetzt werden müssen, wählt man die am nächsten liegenden aus. Auf diese Weise konnten wertvolle Szenen gerettet und die Fehler fast unsichtbar gemacht werden.